Фінансові новини

- |

- 04.03.26

- |

- 07:09

- |

-

RSS

RSS - |

- мапа сайту

Авторизация

Генеративний ШІ «божеволіє» після п’яти ітерацій навчання на матеріалах, створених ШІ – дослідження Стендфордського університету

09:47 14.07.2023 |

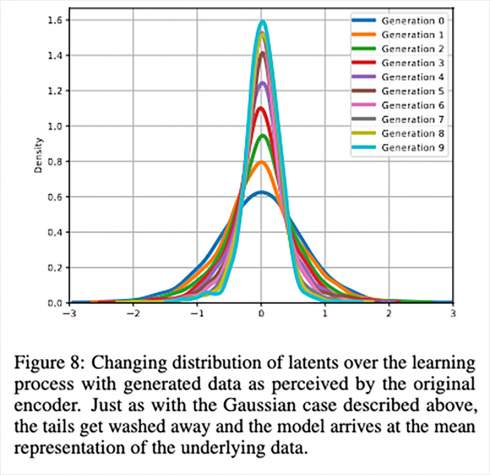

Нове дослідження виявило обмеження сучасних генеративних моделей штучного інтелекту, таких як ChatGPT чи Midjourney. Моделі, які навчаються на даних, згенерованих ШІ, тексти або зображення, мають тенденцію «божеволіти» після п'яти циклів навчання. Зображення вище показує наочний результат таких експериментів.

MAD (Model Autophagy Disorder) - абревіатура, що використовується дослідниками Райс та Стенфордського університету для опису того, як якість видачі моделей ШІ деградує при багаторазовому навчанні на даних, згенерованих ШІ. Як випливає з назви, модель «поїдає сама себе». Він втрачає інформацію про «хвости» (крайні точки) вихідного розподілу даних і починає виводити результати, які більше відповідають середньому представленню.

Навчання LLM (великих мовних моделей) на власних (або аналогічних) результатах створює ефект конвергенції. Це легко побачити на наведеному вище графіку, яким поділився член дослідницької групи Ніколас Пейпернот. Послідовні ітерації навчання на даних, згенерованих LLM, призводять до того, що модель поступово (але досить різко) втрачає доступ до даних, які лежать на периферії графіка.

Дані на краях спектра (те, що має менше варіацій і менш представлене) практично зникають. Через це дані, що залишаються у моделі, тепер менш різноманітні та регресують до середнього значення. Згідно з результатами, потрібно близько п'яти ітерацій, допоки «хвости» вихідного розподілу не зникнуть.

Не підтверджено, що така аутофагія впливає на всі моделі ШІ, але дослідники перевірили його на автокодувальниках, змішаних моделях Гауса та великих мовних моделях. Всі вони широко поширені та працюють у різних сферах: передбачають популярність, обробляють статистику, стискають, обробляють та генерують зображення.

Дослідження говорить, що ми не маємо справу з нескінченним джерелом генерації даних: не можна необмежено отримувати їх, навчивши модель один раз і далі ґрунтуючись на її власних результатах. Якщо модель, що отримала комерційне використання, насправді була навчена на власних вихідних даних, то ця модель, ймовірно, регресувала до середнього значення і є упередженою, тому що не враховує дані, які були б у меншості.

Ще одним важливим моментом, висунутим результатами, є проблема походження даних: тепер стає ще важливішим мати можливість відокремити «вихідні» дані від «штучних». Якщо ви не можете визначити, які дані були створені LLM або програмою для створення зображень, ви можете випадково включити їх у навчальні дані для свого продукту.

На жаль, цей «поїзд» багато в чому пішов: існує ненульова кількість немаркованих даних, які вже були створені цими типами мереж і включені в інші системи. Дані, створені ШІ, стрімко поширюються, і 100% способу відрізнити їх немає, тим більше для самих ШІ.

ТЕГИ

ТОП-НОВИНИ

ПІДПИСКА НА НОВИНИ

Для підписки на розсилку новин введіть Вашу поштову адресу :

Загальна сума державного та гарантованого державою боргу України станом

на кінець січня 2026 року сягнула 215,0 млрд дол. США, збільшившись за

місяць на 1,67 млрд дол.

Загальна сума державного та гарантованого державою боргу України станом

на кінець січня 2026 року сягнула 215,0 млрд дол. США, збільшившись за

місяць на 1,67 млрд дол. Кабмін розширив експериментальний проєкт зі створення власних груп

протиповітряної оборони на підприємствах критичної інфраструктури. Про

це повідомила прем'єр-міністерка Юлія Свириденко.

Кабмін розширив експериментальний проєкт зі створення власних груп

протиповітряної оборони на підприємствах критичної інфраструктури. Про

це повідомила прем'єр-міністерка Юлія Свириденко. Від 2 березня банкноти номіналами 1, 2, 5 і 10 гривень зразків 2003-2007

років замінюються на відповідні обігові монети, повідомив Національний

банк України.

Від 2 березня банкноти номіналами 1, 2, 5 і 10 гривень зразків 2003-2007

років замінюються на відповідні обігові монети, повідомив Національний

банк України. Україна нещодавно досягла домовленості з Експортно-імпортним банком

Китаю (China EXIM) про реструктуризацію залучених раніше під державні

гарантії кредитів, повідомив заступник голови місії Фонду в Україні

Тревор Лессард

Україна нещодавно досягла домовленості з Експортно-імпортним банком

Китаю (China EXIM) про реструктуризацію залучених раніше під державні

гарантії кредитів, повідомив заступник голови місії Фонду в Україні

Тревор Лессард  Думка,

що Україна неодмінно буде в ЄС, давно є домінуючою у Європі, а зараз

посилюється розуміння, що процес вступу має бути швидшим за звичний.

Думка,

що Україна неодмінно буде в ЄС, давно є домінуючою у Європі, а зараз

посилюється розуміння, що процес вступу має бути швидшим за звичний. У дорослому віці вивчення англійської рідко починається з нуля. Хтось

уже має кращий рівень, але не може заговорити, хтось роками ходив на

групові заняття й так і не дійшов до впевнених листів чи робочих

дзвінків іноземною.

У дорослому віці вивчення англійської рідко починається з нуля. Хтось

уже має кращий рівень, але не може заговорити, хтось роками ходив на

групові заняття й так і не дійшов до впевнених листів чи робочих

дзвінків іноземною. В Україні стартував оборонний збір на 1 млрд грн для захисту від "Шахедів". Про це повідомляє пресслужба Фонду Сергія Притули. Проєкт під назвою "Єдинозбір" проводиться фондом спільно з 412 бригадою Nemesis та Світовим Конґресом Українців.

В Україні стартував оборонний збір на 1 млрд грн для захисту від "Шахедів". Про це повідомляє пресслужба Фонду Сергія Притули. Проєкт під назвою "Єдинозбір" проводиться фондом спільно з 412 бригадою Nemesis та Світовим Конґресом Українців. Telegram отримав нові функції. Вони вже доступні для звичайних користувачів, і тих, хто платить за Premium.

Telegram отримав нові функції. Вони вже доступні для звичайних користувачів, і тих, хто платить за Premium. OpenAI оголосила про новий раунд фінансування на $110 млрд - один із

найбільших в історії Силіконової долини, який підвищив оцінку компанії

до $730 млрд.

OpenAI оголосила про новий раунд фінансування на $110 млрд - один із

найбільших в історії Силіконової долини, який підвищив оцінку компанії

до $730 млрд.  Samsung оголосила про розширення можливостей супутникового зв'язку для

окремих смартфонів Galaxy, включно з новою серією Galaxy S26, завдяки

співпраці зі світовими операторами телекомунікацій у Північній Америці,

Європі та Японії.

Samsung оголосила про розширення можливостей супутникового зв'язку для

окремих смартфонів Galaxy, включно з новою серією Galaxy S26, завдяки

співпраці зі світовими операторами телекомунікацій у Північній Америці,

Європі та Японії.

Компанія NVIDIA оголосила про співпрацю з провідними телекомунікаційними

компаніями для розробки шостого покоління мобільних мереж, які будуть

орієнтовані на використання штучного інтелекту.

Компанія NVIDIA оголосила про співпрацю з провідними телекомунікаційними

компаніями для розробки шостого покоління мобільних мереж, які будуть

орієнтовані на використання штучного інтелекту. Китайські науковці розробили новий акумулятор для електромобілів із

щільністю енергії понад 700 Вт·год/кг, що потенційно дає запас ходу

понад 1000 км на одному заряді.

Китайські науковці розробили новий акумулятор для електромобілів із

щільністю енергії понад 700 Вт·год/кг, що потенційно дає запас ходу

понад 1000 км на одному заряді. Американський технологічний гігант NVIDIA оприлюднив фінансові

результати за IV квартал 2025 року та так званий 2026 фінансовий рік,

продемонструвавши стрімке зростання на фоні глобального попиту на

інфраструктуру штучного інтелекту (ШІ).

Американський технологічний гігант NVIDIA оприлюднив фінансові

результати за IV квартал 2025 року та так званий 2026 фінансовий рік,

продемонструвавши стрімке зростання на фоні глобального попиту на

інфраструктуру штучного інтелекту (ШІ). Український фонд стартапів приєднався до

глобальної мережі Microsoft for Startups Investor Network, що дозволить

IT-проєктам отримати до $150 тис. кредитів на сервіси Microsoft Azure.

Український фонд стартапів приєднався до

глобальної мережі Microsoft for Startups Investor Network, що дозволить

IT-проєктам отримати до $150 тис. кредитів на сервіси Microsoft Azure.

HP повідомила, що оперативна пам'ять тепер формує понад третину

собівартості її персональних комп'ютерів. За словами фінансової

директорки Карен Паркхілл, якщо торік витрати на пам'ять і накопичувачі

становили 15-18% від загальної вартості компонентів

HP повідомила, що оперативна пам'ять тепер формує понад третину

собівартості її персональних комп'ютерів. За словами фінансової

директорки Карен Паркхілл, якщо торік витрати на пам'ять і накопичувачі

становили 15-18% від загальної вартості компонентів Компанії Microsoft та SpaceX оголосили про співпрацю для розвитку

глобального доступу до інтернету. Проєкт передбачає використання

супутникового інтернету Starlink для підключення громадських центрів у

різних країнах, зокрема 450 хабів у Кенії.

Компанії Microsoft та SpaceX оголосили про співпрацю для розвитку

глобального доступу до інтернету. Проєкт передбачає використання

супутникового інтернету Starlink для підключення громадських центрів у

різних країнах, зокрема 450 хабів у Кенії. Компанія SpaceX оприлюднила

амбітні плани щодо розвитку своєї технології Direct to Cell, яка дозволить звичайним смартфонам підключатися до супутників без жодного додаткового обладнання.

Компанія SpaceX оприлюднила

амбітні плани щодо розвитку своєї технології Direct to Cell, яка дозволить звичайним смартфонам підключатися до супутників без жодного додаткового обладнання. Dell, Lenovo та інші провідні виробники ПК готують нові ноутбуки

Copilot+, які використовуватимуть процесори NVIDIA на архітектурі ARM.

Dell, Lenovo та інші провідні виробники ПК готують нові ноутбуки

Copilot+, які використовуватимуть процесори NVIDIA на архітектурі ARM.  Фінський стартап Donut Lab оприлюднив результати першого незалежного

тестування своєї твердотільної батареї.

Фінський стартап Donut Lab оприлюднив результати першого незалежного

тестування своєї твердотільної батареї.  Meta та AMD анонсували угоду вартістю $100 мільярдів. У її межах

компанія Марка Цукерберга планує закупити ШІ-чипи для забезпечення

дата-центрів потужністю до 6 гігаватів, а також може отримати 10% акцій

виробника процесорів

Meta та AMD анонсували угоду вартістю $100 мільярдів. У її межах

компанія Марка Цукерберга планує закупити ШІ-чипи для забезпечення

дата-центрів потужністю до 6 гігаватів, а також може отримати 10% акцій

виробника процесорів На мові програмування, написаній у 1950-х, досі тримаються 95% трансакцій у банкоматах США

На мові програмування, написаній у 1950-х, досі тримаються 95% трансакцій у банкоматах США